2022年1月19日整理发布:自从只能识别支票和信封上的手写字符以来,深度学习已经取得了长足的进步。如今,深度神经网络已成为许多计算机视觉应用的关键组成部分,从照片和视频编辑器到医疗软件和自动驾驶汽车。

大致仿照大脑的结构,神经网络已经更接近于像我们人类一样看待世界。但他们还有很长的路要走,在人类永远不会犯错的情况下犯错。

这些情况,通常称为对抗性示例,以令人困惑的方式改变了 AI 模型的行为。对抗性机器学习是当前人工智能系统面临的最大挑战之一。它们可能导致机器学习模型以不可预测的方式失败或容易受到网络攻击。

创建能够抵御对抗性攻击的人工智能系统已成为一个活跃 的 研究领域,也是人工智能会议上讨论的热门话题。在计算机视觉中,保护深度学习系统免受对抗性攻击的一种有趣方法是应用神经科学中的发现来缩小神经网络和哺乳动物视觉系统之间的差距。

使用这种方法,麻省理工学院和 MIT-IBM Watson AI 实验室的研究人员发现,将哺乳动物视觉皮层的特征直接映射到深度神经网络上,可以创建在行为上更可预测且对对抗性扰动更稳健的 AI 系统。在bioRxiv 预印本服务器上发表的一篇论文中,研究人员介绍了 VOneNet,这是一种将当前深度学习技术与受神经科学启发的神经网络相结合的架构。

这项工作是在慕尼黑大学、路德维希马克西米利安大学和奥格斯堡大学的科学家的帮助下完成的,已被 NeurIPS 2020 接受,这是著名的年度 AI 会议之一,该会议将在今年几乎举行。

卷积神经网络

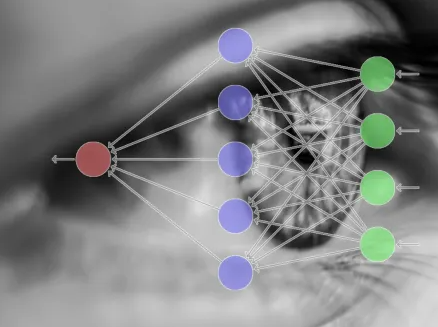

当今计算机视觉中使用的主要架构是卷积神经网络(CNN)。当彼此堆叠时,可以训练多个卷积层以从图像中学习和提取分层特征。较低的层发现一般的模式,如角落和边缘,而较高的层逐渐变得擅长发现更具体的事物,如物体和人。

与传统的全连接网络相比,ConvNets 已被证明更健壮且计算效率更高。然而,CNN 和人类视觉系统处理信息的方式之间仍然存在根本差异。

“深度神经网络(尤其是卷积神经网络)已成为令人惊讶的视觉皮层良好模型——令人惊讶的是,它们更倾向于拟合从大脑收集的实验数据,甚至比为解释神经科学数据而量身定制的计算模型更好。 ,”IBM 麻省理工学院-IBM 沃森人工智能实验室主任大卫考克斯告诉TechTalks。“但并不是每个深度神经网络都能很好地匹配大脑数据,并且大脑和 DNN 之间存在一些持续的差距。”

这些差距中最突出的是对抗性示例,其中细微的扰动(例如小块或一层不易察觉的噪声)可能导致神经网络对其输入进行错误分类。这些变化大多不会被人眼注意到。

“可以肯定的是,欺骗 DNN 的图像永远不会欺骗我们自己的视觉系统,”Cox 说。“DNN 对图像的自然退化(例如,添加噪声)出奇地脆弱也是如此,因此总体而言,鲁棒性似乎是 DNN 的一个悬而未决的问题。考虑到这一点,我们认为这是寻找大脑和 DNN 之间可能有帮助的差异的好地方。”

自 2000 年代初以来, Cox 一直在探索神经科学与人工智能的交叉领域,当时他是麻省理工学院神经科学教授 James DiCarlo 的学生。从那以后,两人继续合作。

“大脑是一个非常强大和有效的信息处理机器,询问我们是否可以从中学习可用于实际目的的新技巧是很诱人的。同时,我们可以利用我们对人工系统的了解来提供指导理论和假设,这些理论和假设可以提出实验来帮助我们理解大脑,”考克斯说。